ChatGPT oder menschlicher Autor?

Fraunhofer SIT forscht an automatisierten Erkennungsmöglichkeiten

Ob Bewerbungsanschreiben, Schulaufsätze Prüfungen oder Programmcodes – mit der Text-KI ChatGPT lassen sich Texte aller Art innerhalb von Sekunden automatisch generieren. Das klappt mal mehr, mal weniger gut – und oft gelingt es Menschen nicht, das Ergebnis verlässlich einzustufen als KI-generiert oder von Menschenhand verfasst.

ChatGPT-Texte erkennen mit Autorschaftsverifikation

Das Fraunhofer SIT forscht an Möglichkeiten, mit ChatGPT erstellte Texte erkennen zu helfen. Unsere textforensischen Expert*innen arbeiten dabei unter anderem mit einer selbst entwickelten Methode zur Autorschaftsverifikation, COAV: Ursprünglich wurde es genutzt, um beispielsweise Plagiate in wissenschaftlichen Arbeiten zu erkennen. Da COAV Texte auf stilistischer Basis vergleicht, lässt sich diese Methode auch für die Erkennung von einem bestimmten "Autor" nutzen, nämlich ChatGPT. Damit werden über Ähnlichkeiten von Textbausteinen und typische aufeinanderfolgende Buchstabenketten die Distanzen zwischen Texten errechnet: Ist der Text näher an GPT oder näher an einem Menschen?

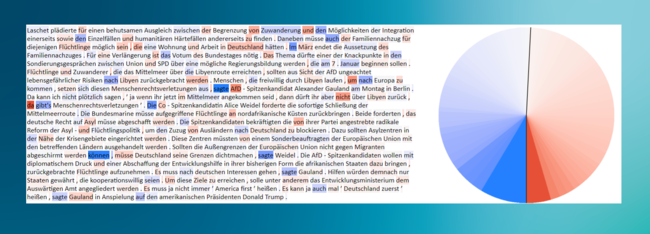

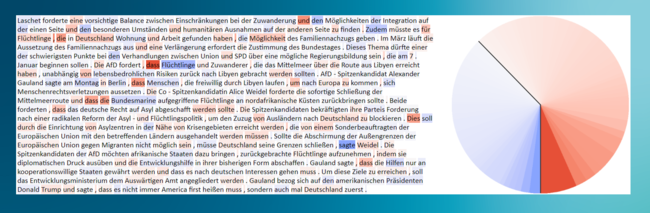

Unser IT-Forensik-Experte Lukas Graner (Abteilung IT-Forensik) hat dies beispielhaft an Nachrichtentexten demonstriert: Vorhandene Online-Nachrichten, von (menschlichen) Journalist*innen verfasst, hat er über ChatGPT umformulieren lassen und mit dem Tool getestet. Blau markierte Textstellen zeigen an, dass sie eher ein Mensch geschrieben hat, rote Markierungen stehen für ChatGPT.

Die Grafiken zeigen anschaulich das Ergebnis: Im ersten Fall sieht man einen Ausschnitt aus einem nachrichtlichen Text aus der Süddeutschen Zeitung mit Markierungen - aufsummiert im Ergebnischart sieht man, dass der blaue Anteil überwiegt. Das Ergebnis: Wahrscheinlich hat ein Mensch diesen Text verfasst.

Für das zweite Beispiel wurde der nachrichtliche Text von ChatGPT mit eigenen stilistischen Präferenzen umformuliert und danach mit COAV getestet. Das Ergebnis zeigt: Dieser Text wurde maschinell erstellt.

- Mensch oder Maschine - wer hat das erstellt?

KI-Inhalte kennzeichnen und erkennen - Challenges and Strategies in Detection of AI-Generated Content

Vortragsfolien zum Download (PDF, 1,01 MB) - Mehr Infos zu unserer IT-Forensik-Forschung

- Wissenschaftliches paper zu COAV

- Weitere Forschung zu Autorschaftsverifikation

Weitere Methoden zur Erkennung von ChatGPT-Texten

Es gibt noch weitere Forschungsansätze in der Textforensik, die sich damit befassen, wie sich KI-generierten Texten auf die Schliche kommen lässt – ebenfalls mit automatisierten KI-Tools. Es gibt beispielsweise

- GPT Zero: eine App, die ein Informatikstudent der Princeton University entwickelt hat (https://gptzero.me/)

- DetectGPT: eine Web-App, die noch in der Experimentierphase ist, das paper dazu findet sich hier: https://arxiv.org/pdf/2301.11305v1.pdf)

- Watermarking for Large Language Models: Ein Vorschlag von Forschenden der Universität Maryland – sie zeigen, wie sich digitale Wasserzeichen in maschinell generierte Texte einflechten lassen, sodass direkt angezeigt werden kann, dass es sich hier um einen KI-Text handelt, der ohne menschliche Hilfe entstanden ist. https://deepai.org/publication/a-watermark-for-large-language-models

Einen Überblick über weitere Tools bietet die Seite SEO.AI, die ihre Auflistung auch regelmäßig aktualisiert.

Bei Erkennungswerkzeugen sollte jedoch nicht blind der Technik vertraut werden, sondern diese auch kritisch betrachtet werden. Denn die Tools arbeiten nie zu 100 Prozent zuverlässig, es gibt immer eine False-Positive-Rate, die Texte fälschlicherweise als KI-generiert klassifiziert; oder auch der umgekehrte Fall, dass KI-Texte nicht als solche erkannt werden. Wegen zu niedriger Erkennungsraten hat Open AI den eigenen KI-Text-Erkennungsdienst wieder offline genommen: "As of July 20, 2023, the AI classifier is no longer available due to its low rate of accuracy." (LINK)

Prüfende an Universitäten sowie Lehrpersonal an Schulen sollten sich deshalb nie völlig auf ein KI-Text-Erkennungstool verlassen. Es kann aber als ein erster Indikator dienen, mit welchen Prüflingen oder Schülerinnen/Schülern eventuell ein Gespräch über den Inhalt des verfassten Texts geführt werden sollte.

Verwechslung mit Plagiatserkennung

KI-Text-Erkennungstools sollten nicht verwechselt werden mit Plagiatserkennung. Es gibt schon lange Tools, mit denen man Plagiate erkennen kann, also wenn Texte aus Quellen kopiert und dabei nicht referenziert werden. Diese haben sehr hohe Erkennungsraten, da sie technisch völlig anders funktionieren. Dort wird mit Sequenzen kryptografischer Hashs gearbeitet, die sehr zuverlässig sind. Bei langen Passagen und einer Übereinstimmung kann hier sicher von einem Plagiat ausgegangen werden.